FÍSICA.

Ciencia que estudia las propiedades de la materia y de la energía y establece las leyes que explican los fenómenos naturales, excluyendo los que modifican la estructura molecular de los cuerpos. La física (del griego φύσις physis, que significa «naturaleza») es la ciencia que estudia las propiedades y el comportamiento de la materia y la energía, así como el tiempo y el espacio. En términos más generales, es el análisis general de la naturaleza, llevado a cabo con el fin de entender cómo el mundo y el universo se comportan. La física estudia, por lo tanto, un amplio rango de campos y fenómenos naturales, desde las partículas subatómicas y sus interacciones, hasta la formación, origen, futuro y evolución del Universo, pasando por una multitud de fenómenos naturales cotidianos.

Mecánica clásica

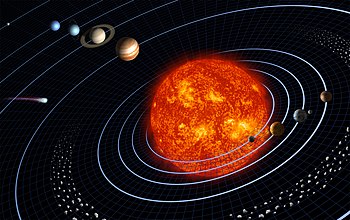

El Sistema Solar puede ser explicado con gran aproximación mediante la mecánica clásica, concretamente, mediante las leyes de Newton y la ley de la gravitación universal de Newton. Solo algunas pequeñas desviaciones en el perihelio de mercurio, que fueron descubiertas tardíamente, no podían ser explicadas por la teoría de Newton y solo pudieron ser explicadas mediante la teoría de la relatividad general de Einstein.

La mecánica clásica es la ciencia que estudia las leyes del comportamiento de cuerpos físicos macroscópicos en reposo y a velocidades pequeñas comparadas con la velocidad de la luz.

Existen varias formulaciones diferentes, en mecánica clásica, para describir un mismo fenómeno natural que, independientemente de los aspectos formales y metodológicos que utilizan, llegan a la misma conclusión.

- La mecánica vectorial, deviene directamente de las leyes de Newton, por eso también se le conoce como «mecánica newtoniana». Es aplicable a cuerpos que se mueven en relación a un observador a velocidades pequeñas comparadas con la de la luz. Fue construida en un principio para una sola partícula moviéndose en un campo gravitatorio. Se basa en el tratamiento de dos magnitudes vectoriales bajo una relación causal: la fuerza y la acción de la fuerza, medida por la variación del momentum (cantidad de movimiento). El análisis y síntesis de fuerzas y momentos constituye el método básico de la mecánica vectorial. Requiere del uso privilegiado de sistemas de referencia inercial.

- La mecánica analítica (analítica en el sentido matemático de la palabra y no filosófico). Sus métodos son poderosos y trascienden de la Mecánica a otros campos de la física. Se puede encontrar el germen de la mecánica analítica en la obra de Leibniz que propone para solucionar los problemas mecánicos otras magnitudes básicas (menos oscuras según Leibniz que la fuerza y el momento de Newton), pero ahora escalares, que son: la energía cinética y el trabajo. Estas magnitudes están relacionadas de forma diferencial. La característica esencial es que, en la formulación, se toman como fundamentos primeros principios generales (diferenciales e integrales), y que a partir de estos principios se obtienen analíticamente las ecuaciones de movimiento.

Aproximaciones de la mecánica clásica

La mecánica clásica fue concebida como un sistema que permitiera explicar adecuadamente el movimiento de los cuerpos relacionándolo con las causas que los originan, es decir, las fuerzas. La mecánica clásica busca hacer una descripción tanto cualitativa (¿qué y cómo ocurre?), como cuantitativa (¿en qué cantidad ocurre?) del fenómeno en cuestión. En este sentido, la ciencia mecánica podría ser construida desde dos aproximaciones alternativas:

- la aproximación empírica

- la aproximación analítica

Mecánica newtoniana

Cinemática – Tiempo – Posición – Velocidad – Aceleración – Dinámica – Masa – Fuerza – Momento de fuerza – Energía – Energía cinética – Energía potencial – leyes de Newton – Momento – Inercia – Fricción – Estática (mecánica) – Sistema de referencia inercial – Sistema de referencia no inercial – Fuerza conservativa

Mecánica analítica

Mecánica lagrangiana – Mecánica hamiltoniana – Fuerza ficticia – Ecuaciones de Euler (sólidos) – Ecuaciones de Euler-Lagrange – Principio de Hamilton – Acción (física) – Principio de acción – Espacio de configuración – Momento conjugado

Mecánica cuántica

La mecánica cuántica es una disciplina de la Física encargada de brindar una descripción fundamental de la naturaleza a escalas espaciales pequeñas. Surge tímidamente en los inicios del siglo XX dentro de las tradiciones más profundas de la física para dar una solución a problemas para los que las teorías conocidas hasta el momento habían agotado su capacidad de explicar, como la llamada catástrofe ultravioleta en la radiación de cuerpo negro predicha por la física estadística clásica y la inestabilidad de los átomos en el modelo atómico de Rutherford. La primera propuesta de un principio propiamente cuántico se debe a Max Planck en 1900, para resolver el problema de la radiación de cuerpo negro, que será duramente cuestionado, hasta que Albert Einstein lo convierte en el principio que exitosamente pueda explicar el efecto fotoeléctrico. Las primeras formulaciones matemáticas completas de la mecánica cuántica no se alcanzan hasta mediados de la década de 1920, sin que hasta el día de hoy se tenga una interpretación coherente de la teoría, en particular del problema de la medición.

La mecánica cuántica propiamente dicha no incorpora a la relatividad en su formulación matemática. La parte de la mecánica cuántica que incorpora elementos relativistas de manera formal para abordar diversos problemas se conoce como mecánica cuántica relativista o ya, en forma más correcta y acabada, teoría cuántica de campos (que incluye a su vez a la electrodinámica cuántica, cromodinámica cuántica y teoría electrodébil dentro del modelo estándar) y más generalmente, la teoría cuántica de campos en espacio-tiempo curvo. La única interacción elemental que no se ha podido cuantizar hasta el momento ha sido la interacción gravitatoria. Este problema constituye entonces uno de los mayores desafíos de la física del siglo XXI.

La mecánica cuántica proporciona el fundamento de la fenomenología del átomo, de su núcleo y de las partículas elementales (lo cual requiere necesariamente el enfoque relativista). También su impacto en teoría de la información, criptografía y química ha sido decisivo entre esta misma.

FÍSICA Contexto histórico

La mecánica cuántica es, cronológicamente hablando, la última de las grandes ramas de la física. Se formuló a principios del siglo XX, casi al mismo tiempo que la teoría de la relatividad, aunque el grueso de la mecánica cuántica se desarrolló a partir de 1920 (siendo la teoría de la relatividad especial de 1905 y la teoría general de la relatividad de 1915).

Además al advenimiento de la mecánica cuántica existían diversos problemas no resueltos en la electrodinámica clásica. El primero de estos problemas era la emisión de radiación de cualquier objeto en equilibrio, llamada radiación térmica, que es la que proviene de la vibración microscópica de las partículas que lo componen. Usando las ecuaciones de la electrodinámica clásica, la energía que emitía esta radiación térmica tendía al infinito si se suman todas las frecuencias que emitía el objeto, con ilógico resultado para los físicos. También la estabilidad de los átomos no podía ser explicada por el electromagnetismo clásico, y la noción de que el electrón fuera o bien una partícula clásica puntual o bien una cáscara esférica de dimensiones finitas resultaban igualmente problemáticas para esto.

Espín – Catástrofe ultravioleta – Colapso de la función de onda – Conmutador de dos operadores – Constante de Planck – Constante de acoplamiento – Contacto de punto cuántico – Correlación electrónica – Cosmología cuántica – Cuantización – Cuanto – Cuerpo negro – Ecuación de Dirac – Ecuación de Klein-Gordon – Ecuación de Schrödinger – Efecto Compton – Efecto Josephson – Efecto Lamb – Efecto fotoeléctrico – Efecto pantalla – Efecto túnel – Partículas idénticas

FÍSICA Electromagnetismo

El electromagnetismo es una rama de la física que estudia y unifica los fenómenos eléctricos y magnéticos en una sola teoría, cuyos fundamentos fueron presentados por Michael Faraday y formulados por primera vez de modo completo por James Clerk Maxwell. La formulación consiste en cuatro ecuaciones diferenciales vectoriales que relacionan el campo eléctrico, el campo magnético y sus respectivas fuentes materiales (corriente eléctrica, polarización eléctrica y polarización magnética), conocidas como ecuaciones de Maxwell.

El electromagnetismo es una teoría de campos; es decir, las explicaciones y predicciones que provee se basan en magnitudes físicas vectoriales o tensoriales dependientes de la posición en el espacio y del tiempo. El electromagnetismo describe los fenómenos físicos macroscópicos en los cuales intervienen cargas eléctricas en reposo y en movimiento, usando para ello campos eléctricos y magnéticos y sus efectos sobre las sustancias sólidas, líquidas y gaseosas. Por ser una teoría macroscópica, es decir, aplicable solo a un número muy grande de partículas y a distancias grandes respecto de las dimensiones de estas, el electromagnetismo no describe los fenómenos atómicos y moleculares, para los que es necesario usar la mecánica cuántica.

El electromagnetismo es considerado como una de las cuatro fuerzas fundamentales del universo actualmente conocido.

FÍSICA Historia

Desde la antigua Grecia se conocían los fenómenos magnéticos y eléctricos pero no es hasta inicios del siglo XVII donde se comienza a realizar experimentos y a llegar a conclusiones científicas de estos fenómenos. Durante estos dos siglos, XVII y XVIII, grandes hombres de ciencia como William Gilbert, Otto von Guericke, Stephen Gray, Benjamin Franklin, Alessandro Volta entre otros estuvieron investigando estos dos fenómenos de manera separada y llegando a conclusiones coherentes con sus experimentos.

A principios del siglo XIX Hans Christian Ørsted encontró evidencia empírica de que los fenómenos magnéticos y eléctricos estaban relacionados. De ahí es que los trabajos de físicos como André-Marie Ampère, William Sturgeon, Joseph Henry, Georg Simon Ohm, Michael Faraday en ese siglo, son unificados por James Clerk Maxwell en 1861 con un conjunto de ecuaciones que describían ambos fenómenos como uno solo, como un fenómeno electromagnético.

Las ahora llamadas ecuaciones de Maxwell demostraban que los campos eléctricos y los campos magnéticos eran manifestaciones de un solo campo electromagnético. Además describía la naturaleza ondulatoria de la luz, mostrándola como una onda electromagnética. Con una sola teoría consistente que describía estos dos fenómenos antes separados, los físicos pudieron realizar varios experimentos prodigiosos e inventos muy útiles como la bombilla eléctrica por Thomas Alva Edison o el generador de corriente alterna por Nikola Tesla. El éxito predictivo de la teoría de Maxwell y la búsqueda de una interpretación coherente de sus implicaciones, fue lo que llevó a Albert Einstein a formular su teoría de la relatividad que se apoyaba en algunos resultados previos de Hendrik Antoon Lorentz y Henri Poincaré.

En la primera mitad del siglo XX, con el advenimiento de la mecánica cuántica, el electromagnetismo tenía que mejorar su formulación con el objetivo de que fuera coherente con la nueva teoría. Esto se logró en la década de 1940 cuando se completó una teoría cuántica electromagnética o mejor conocida como electrodinámica cuántica.

Carga eléctrica – Electricidad – Magnetismo – Campo electromagnético – Campo magnético – Densidad de Flujo Eléctrico – Densidad de corriente – Densidad de flujo magnético – Ecuaciones de Maxwell – Flujo magnético – Frecuencia extremadamente alta – Fuerza de Lorentz – Fuerza electromotriz – Fuerza intermolecular – Fuerza magnética – Ley de Ampère – Ley de Coulomb – Ley de Faraday – Ley de Gauss – Ley de Lenz – Corriente de desplazamiento – Inducción electromagnética – Onda electromagnética – Permeabilidad magnética – Permitividad – Polarización electromagnética – Potencial Electrotónico – Presión de radiación

Electrodinámica

Electrodinámica clásica (CED)

Albert Einstein desarrolló la teoría de la relatividad especial merced a un análisis de la electrodinámica. Durante finales del siglo XIX los físicos se percataron de una contradicción entre las leyes aceptadas de la electrodinámica y la mecánica clásica. En particular, las ecuaciones de Maxwell predecían resultados no intuitivos como que la velocidad de la luz es la misma para cualquier observador y que no obedece a la invariancia galileana. Se creía, pues, que las ecuaciones de Maxwell no eran correctas y que las verdaderas ecuaciones del electromagnetismo contenían un término que se correspondería con la influencia del éter lumínico.

Después de que los experimentos no arrojasen ninguna evidencia sobre la existencia del éter, Einstein propuso la revolucionaria idea de que las ecuaciones de la electrodinámica eran correctas y que algunos principios de la mecánica clásica eran inexactos, lo que le llevó a la formulación de la teoría de la relatividad especial.

Unos quince años antes del trabajo de Einstein, Emil Wiechert y, más tarde, Alfred-Marie Liénard buscaron las expresiones de los campos electromagnéticos de cargas en movimiento. Esas expresiones, que incluían el efecto del retardo de la propagación de la luz, se conocen ahora como potenciales de Liénard-Wiechert. Un hecho importante que se desprende del retardo es que un conjunto de cargas eléctricas en movimiento ya no puede ser descrito de manera exacta mediante ecuaciones que sólo dependa de las velocidades y posiciones de las partículas. En otras palabras, eso implica que el lagrangiano debe contener dependencias de los «grados de libertad» internos del campo.

Electrónica

La electrónica es la rama de la física y especialización de la ingeniería, que estudia y emplea sistemas cuyo funcionamiento se basa en la conducción y el control del flujo de los electrones u otras partículas cargadas eléctricamente.

Utiliza una gran variedad de conocimientos, materiales y dispositivos, desde los semiconductores hasta las válvulas termoiónicas. El diseño y la gran construcción de circuitos electrónicos para resolver problemas prácticos forman parte de la electrónica y de los campos de la ingeniería electrónica, electromecánica y la informática en el diseño de software para su control. El estudio de nuevos dispositivos semiconductores y su tecnología se suele considerar una rama de la física, más concretamente en la rama de ingeniería de materiales.

Historia

El funcionamiento del siguiente dispositivo está basado en el efecto Edison. Edison fue el primero que observó en 1883 la emisión termoiónica, al colocar una lámina dentro de una bombilla para evitar el ennegrecimiento que producía en la ampolla de vidrio el filamento de carbón. Cuando se polarizaba positivamente la lámina metálica respecto al filamento, se producía una pequeña corriente entre el filamento y la lámina. Este hecho se producía porque los electrones de los átomos del filamento, al recibir una gran cantidad de energía en forma de calor, escapaban de la atracción del núcleo (emisión termoiónica) y, atravesando el espacio vacío dentro de la bombilla, eran atraídos por la polaridad positiva de la lámina.

El ingeniero británico Sir John Ambrose Fleming (1849-1945) aplicó el efecto Edison a un tubo para detectar las ondas hertzianas e inventó así el DIODO, primer tubo electrónico en el que se había hecho el vacío y en cuyo interior existía un ÁNODO (electrodo positivo) y un CÁTODO (electrodo negativo). El último, al alcanzar el estado de incandescencia, emitía electrones con carga negativa que eran atraídos por el ánodo; es decir, el diodo actuaba como una válvula que solo dejaba pasar la corriente en un sentido.

El otro gran paso lo dio Lee De Forest cuando inventó el triodo en 1906. Este dispositivo es básicamente como el diodo de vacío, pero se le añadió una rejilla de control situada entre el cátodo y la placa, con el objeto de modificar la nube electrónica del cátodo, variando así la corriente de placa. Este fue un paso muy importante para la fabricación de los primeros amplificadores de sonido, receptores de radio, televisores, etc.

Lee De Forest es considerado el «Padre de la electrónica», ya que antes del triodo, solo nos limitábamos a convertir la corriente alterna en corriente directa o continua, o sea, solo se construían las fuentes de alimentación, pero con la creación del triodo de vacío, vino la amplificación de todo tipo de señales, sobre todo la de audio, la radio, la TV y todo lo demás, esto hizo que la industria de estos equipos tuvieran un repunte tan grande que ya para las décadas superiores a 1930 se acuñara la palabra por primera vez de «electrónica» para referirse a la tecnología de estos equipos emergentes.

Conforme pasaba el tiempo, las válvulas de vacío se fueron perfeccionando y mejorando, apareciendo otros tipos, como los tetrodos (válvulas de cuatro electrodos), los pentodos (cinco electrodos), otras válvulas para aplicaciones de alta potencia, etc. Dentro de los perfeccionamientos de las válvulas se encontraba su miniaturización.

Pero fue definitivamente con el transistor, aparecido de la mano de Bardeen y Brattain, de la Bell Telephone Company, en 1948, cuando se permitió aún una mayor miniaturización de aparatos tales como las radios. El transistor de unión apareció algo más tarde, en 1949. Este es el dispositivo utilizado actualmente para la mayoría de las aplicaciones de la electrónica. Sus ventajas respecto a las válvulas son entre otras: menor tamaño y fragilidad, mayor rendimiento energético, menores tensiones de alimentación, etc. El transistor no funciona en vacío como las válvulas, sino en un estado sólido semiconductor (silicio), razón por la que no necesita centenares de voltios de tensión para funcionar.

A pesar de la expansión de los semiconductores, todavía se siguen utilizando las válvulas en pequeños círculos audiófilos, porque constituyen uno de sus mitos1 más extendidos.

El transistor tiene tres terminales (el emisor, la base y el colector) y se asemeja a un triodo: la base sería la rejilla de control, el emisor el cátodo, y el colector la placa. Polarizando adecuadamente estos tres terminales se consigue controlar una gran corriente de colector a partir de una pequeña corriente de base.

En 1958 se desarrolló el primer circuito integrado, que alojaba seis transistores en un único chip. En 1970 se desarrolló el primer microprocesador, Intel 4004. En la actualidad, los campos de desarrollo de la electrónica son tan vastos que se ha dividido en varias disciplinas especializadas. La mayor división es la que distingue la electrónica analógica de la electrónica digital.

La electrónica es, por tanto, una de las ramas de la ingeniería con mayor proyección en el futuro, junto con la informática.

FÍSICA Aplicaciones de la electrónica

La electrónica desarrolla en la actualidad una gran variedad de tareas. Los principales usos de los circuitos electrónicos son el control, el procesado, la distribución de información, la conversión y la distribución de la energía eléctrica. Estos usos implican la creación o la detección de campos electromagnéticos y corrientes eléctricas. Entonces se puede decir que la electrónica abarca en general las siguientes áreas de aplicación:

- Electrónica de control

- Telecomunicaciones

- Electrónica de potencia

Resistencia – Capacidad – Diodo – Autoinducción – Circuito eléctrico

Onda

En física, una onda (del latín unda) consiste en la propagación de una perturbación de alguna propiedad del espacio, por ejemplo, densidad, presión, campo eléctrico o campo magnético, implicando un transporte de energía sin transporte de materia. El espacio perturbado puede contener materia (aire, agua, etc) o no (vacío).

La magnitud física cuya perturbación se propaga en el medio se expresa como una función tanto de la posición como del tiempo

donde

Definiciones

Una vibración puede definir las características necesarias y suficientes que caracterizan un fenómeno como onda. El término suele ser entendido intuitivamente como el transporte de perturbaciones en el espacio, donde se considera el espacio como un medio en el que pueden producirse y propagarse dichas perturbaciones a través de él, al variar alguna de sus propiedades medibles.

La teoría de ondas se conforma como una característica rama de la física que se ocupa de las propiedades de los fenómenos ondulatorios independientemente de cual sea su origen físico (Ostrovsky y Potapov, 1999). Una peculiaridad de estos fenómenos ondulatorios es que a pesar de que el estudio de sus características no depende del tipo de onda en cuestión, los distintos orígenes físicos que provocan su aparición les confieren propiedades muy particulares que las distinguen de unos fenómenos a otros. Por ejemplo, la acústica se diferencia de la óptica en que las ondas sonoras están relacionadas con aspectos más mecánicos que las ondas electromagnéticas (que son las que gobiernan los fenómenos ópticos). Conceptos tales como masa, cantidad de movimiento, inercia o elasticidad son conceptos importantes para describir procesos de ondas sonoras, a diferencia de en las ópticas, donde estas no tienen una especial relevancia. Por lo tanto, las diferencias en el origen o naturaleza de las ondas producen ciertas propiedades que caracterizan cada onda, manifestando distintos efectos en el medio en que se propagan (por ejemplo, en el caso del aire: vórtices, ondas de choque; en el caso de los sólidos: dispersión; y en el caso del electromagnetismo presión de radiación).

Óptica

Se considera a la óptica como la parte de la física que trata de la luz y de los fenómenos luminosos.

En la Edad Antigua se conocía la propagación rectilínea de la luz, la reflexión y refracción. Varios filósofos y matemáticos griegos escribieron tratados sobre óptica. Entre ellos: Empédocles y Euclides.

Ya en la Edad Moderna René Descartes consideraba la luz como una onda de presión transmitida a través de un medio elástico perfecto (el éter) que llenaba el espacio. Atribuyó los diferentes colores a movimientos rotatorios de diferentes velocidades de las partículas en el medio.

La ley de la refracción fue descubierta experimentalmente en 1621 por Willebrord Snell. En 1657 Pierre de Fermat anunció el principio del tiempo mínimo y a partir de él dedujo la ley de la refracción.

En la refracción el rayo de luz que se atraviesa de un medio transparente a otro, se denomina rayo incidente; el rayo de luz que se desvía al ingresar al segundo medio transparente se denomina rayo refractado; el ángulo en que el rayo incidente, al ingresar al segundo medio, forma con la perpendicular al mismo, se denomina ángulo de incidencia; el ángulo que el rayo incidente forma con el rayo refractado, al desviarse, se denomina ángulo de refracción o ángulo indeterminado. Este último varía directamente en relación a la diferencia entre los índices de refracción de ambas superficies (dependientes a su vez de la diferencia de la velocidad de la luz a través de distintos materiales)

Interferencia y difracción

Robert Boyle y Robert Hooke descubrieron de forma independiente el fenómeno de interferencia conocido como anillos de Newton, cuya explicación teórica propuso el propio Isaac Newton. Hooke también observó la presencia de luz en la sombra geométrica, debido a la difracción, fenómeno que ya había sido descubierto por Francesco Maria Grimaldi. Hooke pensaba que la luz consistía en vibraciones propagadas instantáneamente a gran velocidad y creía que en un medio homogéneo cada vibración generaba una esfera que crece de forma regular. Con estas ideas, Hooke intentó explicar el fenómeno de la refracción e interpretar los colores. Sin embargo, los estudios que aclararon las propiedades de los colores fueron desarrollados por Newton que descubrió en 1666 que la luz blanca puede dividirse en sus colores componentes mediante un prisma y encontró que cada color puro se caracteriza por una refractabilidad específica. Las dificultades que la teoría ondulatoria se encontraba para explicar la propagación rectilínea de la luz y la polarización (descubierta por Huygens) llevaron a Newton a inclinarse por la teoría corpuscular, que supone que la luz se propaga desde los cuerpos luminosos en forma de partículas.

En la época en que Newton publicó su teoría del color, no se conocía si la luz se propagaba instantáneamente o no. El descubrimiento de la velocidad finita de la luz lo realizó en 1675 Olaf Roemer a partir de observaciones de los eclipses de Júpiter.

Primeras teorías y otros fenómenos

Por su parte, Hooke fue de los primeros defensores de la teoría ondulatoria que fue extendida y mejorada por Christian Huygens que enunció el principio que lleva su nombre, según el cual cada punto perturbado por una onda puede considerarse como el centro de una nueva onda secundaria, la envolvente de estas ondas secundarias define el frente de onda en un tiempo posterior. Con la ayuda de este principio, consiguió deducir las leyes de la reflexión y refracción. También pudo interpretar la doble refracción del espato de Islandia, fenómeno descubierto en 1669 por Erasmus Bartholinus, gracias a la suposición de la transmisión de una onda secundaria elipsoidal, además de la principal de forma esférica. Durante esta investigación Huygens descubrió la polarización. Cada uno de los dos rayos emergentes de la refracción del espato de Islandia puede extinguirse haciéndolo pasar por un segundo cristal del mismo material, rotado alrededor de un eje con la misma dirección que el rayo luminoso. Fue sin embargo Newton el que consiguió interpretar este fenómeno, suponiendo que los rayos tenían “lados”, propiedad que le pareció una objeción insuperable para la teoría ondulatoria de la luz, ya que en aquella época los científicos sólo estaban familiarizados con las ondas longitudinales.

El prestigio de Newton, indujo el rechazo por parte de la comunidad científica de la teoría ondulatoria, durante casi un siglo, con algunas excepciones, como la de Leonhard Euler. No fue hasta el comienzo del Siglo XIX en que nuevos progresos llevaron a la aceptación generalizada de la teoría ondulatoria. El primero de ellos fue la enunciación por Thomas Young en 1801, del principio de interferencia y la explicación de los colores de películas delgadas. Sin embargo, como fueron expresadas en términos cualitativos no consiguieron reconocimiento generalizado. En esta misma época Étienne-Louis Malus describió la polarización por reflexión, en 1808 observó la reflexión del Sol desde una ventana a través de un cristal de espato de Islandia y encontró que las dos imágenes birrefringentes variaban sus intensidades relativas al rotar el cristal, aunque Malus no intentó interpretar el fenómeno.

Color – Fotometría – Interferencia – Luz – Óptica geométrica – Difracción – Difracción de Fraunhofer – Difracción de Fresnel – Efecto Kerr – Efecto Pockels – Efecto electroóptico – Efecto estroboscópico – Dispersión de la luz – Índice de refracción

Acústica

Fuente de sonido omnidireccional en una cámara anecoica.

La acústica es una rama de la física interdisciplinaria que estudia el sonido, infrasonido y ultrasonido, es decir ondas mecánicas que se propagan a través de la materia (tanto sólida como líquida o gaseosa) (no pueden propagarse en el vacío) por medio de modelos físicos y matemáticos. A efectos prácticos, la acústica estudia la producción, transmisión, almacenamiento, percepción o reproducción del sonido. La ingeniería acústica es la rama de la ingeniería que trata de las aplicaciones tecnológicas de la acústica.

La acústica considera el sonido como una vibración que se propaga generalmente en el aire a una velocidad de 343 m/s (aproximadamente 1 km cada 3 segundos), o 1235 km/h en condiciones normales de presión y temperatura (1 atm y 20 °C).

Primeros trabajos

La acústica tiene su origen en la Antigua Grecia y Roma, entre los siglos VI a. C. y I d. C. Comenzó con la música, que se venía practicando como arte desde hacía miles de años, pero no había sido estudiada de forma científica hasta que Pitágoras se interesó por la naturaleza de los intervalos musicales. Quería saber por qué algunos intervalos sonaban más bellos que otros, y llegó a respuestas en forma de proporciones numéricas. Aristóteles (384 a 322 a. C.) comprobó que el sonido consistía en contracciones y expansiones del aire «cayendo sobre y golpeando el aire próximo», una buena forma de expresar la naturaleza del movimiento de las ondas. Alrededor del año 20 a. C., el arquitecto e ingeniero romano Vitruvio escribió un tratado sobre las propiedades acústicas de los teatros, incluyendo temas como la interferencia, los ecos y la reverberación; esto supuso el comienzo de la acústica arquitectónica.

La comprensión de la física de los procesos acústicos avanzó rápidamente durante y después de la Revolución Científica. Galileo (1564-1642) y Mersenne (1588-1648) descubrieron de forma independiente todas las leyes de la cuerda vibrante, terminando así el trabajo que Pitágoras había comenzado 2000 años antes. Galileo escribió «Las ondas son producidas por las vibraciones de un cuerpo sonoro, que se difunden por el aire, llevando al tímpano del oído un estímulo que la mente interpreta como sonido», sentando así el comienzo de la acústica fisiológica y de la psicológica.

Entre 1630 y 1680 se realizaron mediciones experimentales de la velocidad del sonido en el aire por una serie de investigadores, destacando de entre ellos Mersenne. Mientras tanto, Newton (1642-1727) obtuvo la fórmula para la velocidad de onda en sólidos, uno de los pilares de la física acústica (Principia, 1687).

De la Ilustración en adelante

El siglo XVIII vio grandes avances en acústica a manos de los grandes matemáticos de la era, que aplicaron nuevas técnicas de cálculo a la elaboración de la teoría de la propagación de las ondas. En el siglo XIX, los gigantes de la acústica eran Helmholtz en Alemania, que consolidó la acústica fisiológica, y Lord Rayleigh en Inglaterra, que combinó los conocimientos previos con abundantes aportaciones propias en su monumental obra «La teoría del sonido». También durante ese siglo, Wheatstone, Ohm y Henry desarrollaron la analogía entre electricidad y acústica.

Durante el siglo XX aparecieron muchas aplicaciones tecnológicas del conocimiento científico previo. La primera fue el trabajo de Wallace Clement Sabine en la acústica arquitectónica, seguido de muchos otros. La acústica subacuática fue utilizada para detectar submarinos en la Primera Guerra Mundial. La grabación sonora y el teléfono fueron importantes para la transformación de la sociedad global. La medición y análisis del sonido alcanzaron nuevos niveles de precisión y sofisticación a través del uso de la electrónica y la informática. El uso de las frecuencias ultrasónicas permitió nuevos tipos de aplicaciones en la medicina y la industria. También se inventaron nuevos tipos de transductores (generadores y receptores de energía acústica).

Ramas

Algunas ramas de la física acústica:

- Aeroacústica: generación de sonido debido al movimiento violento en el aire.

- Arqueoacústica: estudio sistemático de efectos acústicos en sitios arqueológicos.

- Acústica en física: análisis de los fenómenos sonoros, mediante modelos físicos y matemáticos.

- Acústica arquitectónica: estudio del control del sonido, tanto del aislamiento entre recintos habitables (casas, cuartos o habitaciones), como del acondicionamiento acústico de locales (salas de conciertos, teatros, etc.), amortiguándolo mediante materiales blandos, o reflejándolo con materiales duros para que la construcción o la estructura del lugar permita el máximo aprovechamiento del sonido o bien hacer que en sonido disminuya y no traspase los muros o paredes.

- Psicoacústica: estudia la percepción del sonido en humanos, la capacidad para localizar espacialmente la fuente, es decir su ubicación, la calidad observada de los métodos de compresión de audio, etcétera.

- Bioacústica: estudio de la audición animal (murciélagos, perros, delfines, etc.) y así comprender como utilizan el sentido auditivo (como radares, detectando sonidos de baja frecuencia o como protección para si mismo).

- Acústica ambiental: estudio del sonido en exteriores, el ruido ambiental y sus efectos en las personas y la naturaleza, estudio de fuentes de ruido como el tránsito vehicular, ruido generado por trenes y aviones, establecimientos industriales, talleres, locales de ocio y el ruido producido por el vecindario (la contaminación auditiva).

- Acústica subacuática: relacionada sobre todo con la detección de objetos sumergidos mediante el sonido (se utiliza en barcos o en submarinos sonar).

- Acústica musical: estudio de la producción de sonido en los instrumentos musicales, y de los sistemas de afinación de la escala.

- Electroacústica: estudia el tratamiento electrónico del sonido, incluyendo la captación (micrófono y estudios de grabación), procesamiento (efectos, filtrado comprensión, etc.) amplificación, grabación, producción (altavoces), etc.

- Acústica fisiológica: estudio del funcionamiento del aparato auditivo, desde la oreja a la corteza cerebral (el oído y sus componentes, así como sus repercusiones, enfermedades y trastornos).

- Acústica fonética: análisis de las características acústicas del habla y sus aplicaciones.

- Macro Acústica: estudio de los sonidos extremadamente intensos, como el de las explosiones, turborreactores, entre otros.

Onda sonora – Espectro de frecuencias – Vibración – Ultrasonido –

Teoría de la relatividad

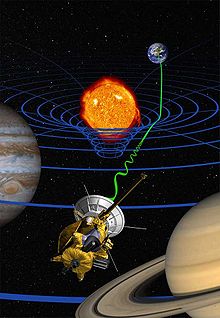

Dibujo artístico sobre la teoría de la relatividad

La teoría de la relatividad incluye tanto a la teoría de la relatividad especial como la de relatividad general, formuladas por Albert Einstein a principios del siglo XX, que pretendían resolver la incompatibilidad existente entre la mecánica newtoniana y el electromagnetismo.

La teoría de la relatividad especial, publicada en 1905, trata de la física del movimiento de los cuerpos en ausencia de fuerzas gravitatorias, en el que se hacían compatibles las ecuaciones de Maxwell del electromagnetismo con una reformulación de las leyes del movimiento.

La teoría de la relatividad general, publicada en 1915, es una teoría de la gravedad que reemplaza a la gravedad newtoniana, aunque coincide numéricamente con ella para campos gravitatorios débiles y «pequeñas» velocidades. La teoría general se reduce a la teoría especial en ausencia de campos gravitatorios.

El 7 de marzo de 2010, la Academia Israelí de Ciencias exhibió públicamente los manuscritos originales de Einstein (redactados en 1905). El documento contiene 46 páginas de textos y fórmulas matemáticas escritas a mano y que fue donado por Einstein a la Universidad Hebrea de Jerusalén en 1925 con motivo de su inauguración.

Conceptos principales

El supuesto básico de la teoría de la relatividad es que la localización de los sucesos físicos, tanto en el tiempo como en el espacio, son relativos al estado de movimiento del observador: así, la longitud de un objeto en movimiento o el instante en que algo sucede, a diferencia de lo que sucede en mecánica newtoniana, no son invariantes absolutos, y diferentes observadores en movimiento relativo entre sí diferirán respecto a ellos (las longitudes y los intervalos temporales, en relatividad son relativos y no absolutos).

Teoría de la relatividad especial – Relatividad General – Causalidad (física) – Cono de luz – Cuadricorriente – Cuadrimomento – Cuadrivector – Cuadrivelocidad – Dilatación del tiempo – E=mc² – Energía en reposo – Equivalencia entre masa y energía – Espacio-tiempo – Eternalismo – Flecha del tiempo – Línea de universo – Paradoja de Bell – Paradoja de los gemelos – Principio de Mach – Principio de covariancia – Velocidad de la luz

Física de partículas, atómica, nuclear y molecular

Antipartícula – Bosón – Bosón de Higgs – Electrón – Fotón – Leptón – Neutrón – Neutrino – Partícula elemental – Positrón – Protón – Quark – Orbital atómico – Orbital molecular

Termodinámica

Máquina térmica típica donde puede observarse la entrada desde una fuente de calor (caldera) a la izquierda y la salida a un disipador de calor (condensador) a la derecha. El trabajo se extrae en este caso mediante una serie de pistones.

La termodinámica es la rama de la física que describe los estados de equilibrio termodinámico a nivel macroscópico. El Diccionario de la lengua española de la Real Academia Española, por su parte, define a la termodinámica como la rama de la física encargada del estudio de la interacción entre el calor y otras manifestaciones de la energía. Constituye una teoría fenomenológica, a partir de razonamientos deductivos, que estudia sistemas reales, sin modelizar y sigue un método experimental. Los estados de equilibrio se estudian y definen por medio de magnitudes extensivas tales como la energía interna, la entropía, el volumen o la composición molar del sistema, o por medio de magnitudes no-extensivas derivadas de las anteriores como la temperatura, presión y el potencial químico; otras magnitudes, tales como la imanación, la fuerza electromotriz y las asociadas con la mecánica de los medios continuos en general también pueden tratarse por medio de la termodinámica.

La termodinámica ofrece un aparato formal aplicable únicamente a estados de equilibrio, definidos como aquel estado hacia «el que todo sistema tiende a evolucionar y caracterizado porque en el mismo todas las propiedades del sistema quedan determinadas por factores intrínsecos y no por influencias externas previamente aplicadas».Tales estados terminales de equilibrio son, por definición, independientes del tiempo, y todo el aparato formal de la termodinámica –todas las leyes y variables termodinámicas– se definen de tal modo que podría decirse que un sistema está en equilibrio si sus propiedades pueden describirse consistentemente empleando la teoría termodinámica. Los estados de equilibrio son necesariamente coherentes con los contornos del sistema y las restricciones a las que esté sometido. Por medio de los cambios producidos en estas restricciones (esto es, al retirar limitaciones tales como impedir la expansión del volumen del sistema, impedir el flujo de calor, etc.), el sistema tenderá a evolucionar de un estado de equilibrio a otro; comparando ambos estados de equilibrio, la termodinámica permite estudiar los procesos de intercambio de masa y energía térmica entre sistemas térmicos diferentes.

Como ciencia fenomenológica, la termodinámica no se ocupa de ofrecer una interpretación física de sus magnitudes. La primera de ellas, la energía interna, se acepta como una manifestación macroscópica de las leyes de conservación de la energía a nivel microscópico, que permite caracterizar el estado energético del sistema macroscópico.7 El punto de partida para la mayor parte de las consideraciones termodinámicas son los que postulan que la energía puede ser intercambiada entre sistemas en forma de calor o trabajo, y que solo puede hacerse de una determinada manera. También se introduce una magnitud llamada entropía, que se define como aquella función extensiva de la energía interna, el volumen y la composición molar que toma valores máximos en equilibrio: el principio de maximización de la entropía define el sentido en el que el sistema evoluciona de un estado de equilibrio a otro. Es la mecánica estadística, íntimamente relacionada con la termodinámica, la que ofrece una interpretación física de ambas magnitudes: la energía interna se identifica con la suma de las energías individuales de los átomos y moléculas del sistema, y la entropía mide el grado de orden y el estado dinámico de los sistemas, y tiene una conexión muy fuerte con la teoría de información. En la termodinámica se estudian y clasifican las interacciones entre diversos sistemas, lo que lleva a definir conceptos como sistema termodinámico y su contorno. Un sistema termodinámico se caracteriza por sus propiedades, relacionadas entre sí mediante las ecuaciones de estado. Estas se pueden combinar para expresar la energía interna y los potenciales termodinámicos, útiles para determinar las condiciones de equilibrio entre sistemas y los procesos espontáneos.

Con estas herramientas, la termodinámica describe cómo los sistemas reaccionan a los cambios en su entorno. Esto se puede aplicar a una amplia variedad de ramas de la ciencia y de la ingeniería, tales como motores, cambios de fase, reacciones químicas, fenómenos de transporte, e incluso agujeros negros.

Historia de la termodinámica

La historia de la termodinámica como disciplina científica se considera generalmente que comienza con Otto von Guericke quien, en 1650, construyó y diseñó la primera bomba de vacío y demostró las propiedades del vacío usando sus hemisferios de Magdeburgo. Guericke fue impulsado a hacer el vacío con el fin de refutar la suposición de Aristóteles que «la naturaleza aborrece el vacío». Poco después de Guericke, el físico y químico Robert Boyle estudió y mejoró los diseños de Guericke y en 1656, en coordinación con el científico Robert Hooke, construyó una bomba de aire. Con esta bomba, Boyle y Hooke observaron una correlación entre la presión, temperatura y volumen. Con el tiempo, se formularon la ley de Boyle, indicando que para un gas a temperatura constante, la presión y el volumen son inversamente proporcionales y otras leyes de los gases.

En 1679, un asociado de Boyle, Denis Papin basándose en estos conceptos, construyó un digestor de vapor, que era un recipiente cerrado con una tapa de cierre hermético en el que el vapor confinado alcanzaba una alta presión, aumentando el punto de ebullición y acortando el tiempo de cocción de los alimentos.

En 1697, el ingeniero Thomas Savery, a partir de los diseños de Papin, construyó el primer motor térmico, seguido por Thomas Newcomen en 1712. Aunque estos primeros motores eran toscos y poco eficientes, atrajeron la atención de los científicos más destacados de la época.

En 1733, Bernoulli usó métodos estadísticos, junto con la mecánica clásica, para extraer resultados de la hidrodinámica, iniciando la mecánica estadística.

En 1781 los conceptos de capacidad calorífica y calor latente, fueron desarrollados por el profesor Joseph Black de la Universidad de Glasgow, donde James Watt trabajó como fabricante de instrumentos. Watt consultó con Black en las pruebas de la máquina de vapor, pero fue Watt quien concibió la idea del condensador externo, aumentando grandemente la eficiencia de la máquina de vapor.

En 1783, Antoine Lavoisier propone la teoría del calórico.

En 1798 Benjamin Thompson, conde de Rumford, demostró la conversión del trabajo mecánico en calor.

Sobre la base de todo este trabajo previo, Sadi Carnot, el «padre de la termodinámica «, publicó en 1824 Reflexiones sobre la energía motriz del fuego, un discurso sobre la eficiencia térmica, la energía, la energía motriz y el motor. El documento describe las relaciones básicas energéticas entre la máquina de Carnot, el ciclo de Carnot y energía motriz, marcando el inicio de la termodinámica como ciencia moderna.

El primer libro de texto sobre termodinámica fue escrito en 1859 por William Rankine, quien originalmente se formó como físico y profesor de ingeniería civil y mecánica en la Universidad de Glasgow. La primera y segunda leyes de la termodinámica surgieron simultáneamente en la década de 1850, principalmente por las obras de Germain Henri Hess, William Rankine, Rudolf Clausius, James Prescott Joule y William Thomson (Lord Kelvin).

Los fundamentos de la termodinámica estadística se establecieron por los físicos como James Clerk Maxwell, Ludwig Boltzmann, Max Planck, Rudolf Clausius, Johannes van der Waals y Josiah Willard Gibbs.

Desde 1873 hasta el 76, el físico matemático estadounidense Josiah Willard Gibbs publicó una serie de tres artículos, siendo la más famosa Sobre el equilibrio de las sustancias heterogéneas. Gibbs demostró cómo los procesos termodinámicos, incluyendo reacciones químicas, se podrían analizar gráficamente. Mediante el estudio de la energía, la entropía, potencial químico, la temperatura y la presión del sistema termodinámico, se puede determinar si un proceso se produce espontáneamente. La termodinámica química y la fisicoquímica fueron desarrolladas además por Walther Nernst, Pierre Duhem, Gilbert N. Lewis, Jacobus Henricus van ‘t Hoff, y Théophile de Donder, entre otros, aplicando los métodos matemáticos de Gibbs.

También fueron de importancia para la termodinámica los desarrollos en termometría y manometría.

Constante de Avogadro – Ley de Avogadro – Ley de Joule – Ley de Boyle – Ley de Dalton – Ley de Charles – Primera ley de la termodinámica – Segunda ley de la termodinámica – Tercera ley de la termodinámica – Temperatura absoluta – Proceso adiabático – Cuerpo negro – Calor – Calorimetría – Compresibilidad – Endotérmico – Entalpía – Entropía – transferencia de calor – Solución – Ley de los gases ideales – Constante de los gases – Calor latente – Proceso isobárico – Proceso isocórico – Proceso isotérmico – Presión – Calor específico

Física estadística

La física estadística o mecánica estadística es una rama de la física que mediante la teoría de la probabilidad es capaz de deducir el comportamiento de los sistemas físicos macroscópicos constituidos por una cantidad estadísticamente significativa de componentes equivalentes a partir de ciertas hipótesis sobre los elementos o partículas que los conforman y sus interacciones mutuas.

Los sistemas macroscópicos son aquellos que tienen un número de partículas cercano a la constante de Avogadro, cuyo valor, de aproximadamente

La importancia del uso de las técnicas estadísticas para estudiar estos sistemas radica en que, al tratarse de sistemas tan grandes es imposible, incluso para las más avanzadas computadoras, llevar un registro del estado físico de cada partícula y predecir el comportamiento del sistema mediante las leyes de la mecánica, además del hecho de que resulta impracticable el conocer tanta información de un sistema real.

La utilidad de la física estadística consiste en ligar el comportamiento microscópico de los sistemas con su comportamiento macroscópico o colectivo, de modo que, conociendo el comportamiento de uno, pueden averiguarse detalles del comportamiento del otro. Permite describir numerosos campos de naturaleza estocástica como las reacciones nucleares; los sistemas biológicos, químicos, neurológicos, entre otros.

Colectividad canónica – Colectividad microcanónica – Colectividad macrocanónica – Estadística de Maxwell-Boltzmann – Estadística de Bose-Einstein – Estadística de Fermi-Dirac – Teorema de equipartición

Física teórica

La física teórica constituye la rama de la física que elabora teorías y modelos usando el lenguaje matemático con el fin de explicar y comprender fenómenos físicos, aportando las herramientas necesarias no solo para el análisis sino para la predicción del comportamiento de los sistemas físicos. El objetivo de la física teórica es comprender el universo elaborando unos modelos matemáticos y conceptuales de la realidad que se utiliza para racionalizar, explicar y predecir los fenómenos de la naturaleza, planteando una teoría física de la realidad.

Aunque trabajos anteriores pueden considerarse parte de esta disciplina, la física teórica cobra especial fuerza desde la formulación de la mecánica analítica (Joseph-Louis de Lagrange, William Rowan Hamilton) y adquiere una relevancia de primera línea a partir de las revoluciones cuántica y relativista de principios del siglo XX (por ejemplo la bomba atómica fue una predicción de la física teórica).

La física teórica tiene una importante relación con la física matemática, en esta última se pone énfasis en analizar las propiedades de las estructuras matemáticas empleadas en la física teórica, y en teorizar posibles generalizaciones que puedan servir como descripciones matemáticas más complejas y generales de los sistemas estudiados en la física teórica.

Método de la física

Todas las ciencias de la naturaleza poseen una característica común: son ciencias experimentales, es decir, los conocimientos acumulados han sido obtenidos mediante la experimentación sistemática. Este procedimiento se denomina método científico experimental o también método empírico-descriptivo.

No obstante, la física teórica crea y usa la matemática adecuada para predecir fenómenos que aún no han sido observados experimentalmente así como otros que nos permiten conocer el universo en formas no accesibles experimentalmente, sobre la base de principios bien demostrados experimentalmente. Pero la demostración final de todo conocimiento en física es experimental y hasta que no se demuestra de esta forma las predicciones de la teoría no se puede estar seguro de la validez de una teoría o modelo. Un ejemplo está en los aceleradores de partículas en los que se busca en muchas ocasiones partículas previstas por el modelo de la física de partículas y frecuentemente se encuentran otras no previstas inicialmente y que hacen cambiar el modelo. Asimismo, las predicciones de la física teórica han indicado a menudo la existencia de partículas no descubiertas y han proporcionado las técnicas adecuadas para su búsqueda experimental, siendo encontradas de forma posterior a su predicción teórica.

Algunos físicos teóricos eminentes

Entre otros muchos los siguientes son algunos de los físicos teóricos más célebres y relevantes:

|

|

|

Teorías centrales

Las teorías dominantes (a veces conocido como teorías central) son el cuerpo de conocimiento de ambos puntos de vista fáctico y científico, y que poseen una calidad científica habitual de pruebas de repetibilidad, y coherencia con los parámetros bien establecidos de la ciencia y la experimentación. No existen teorías dominantes que son generalmente aceptadas, sino teorías que se basan únicamente en sus efectos explicar una amplia variedad de datos, aunque la composición de la detección, y la explicación, son aún posibles temas de debate.

Ejemplos

|

|

Teorías propuestas

Las teorías propuestas de la física son relativamente nuevas teorías que se ocupan del estudio de la física, que incluyen los enfoques científicos, medios para determinar la validez de los modelos y los nuevos tipos de razonamiento utilizados para llegar a la teoría. Sin embargo, algunas teorías propuestas son las teorías que han existido durante décadas y han eludido a los métodos de descubrimiento y de la prueba. Teorías propuestas pueden incluir las teorías marginales en el proceso de establecerse (y, a veces, ganando una mayor aceptación). Las teorías propuestas por lo general no han sido probados

Ejemplos

- Conjuntos causales

- Energía oscura o Constante cosmológica

- Agujero de gusano

- Teoría de la gran unificación

- Gravedad cuántica de bucles

- Teoría M

- Teoría de cuerdas

- Supersimetría

- Teoría del todo

- Teoría de supercuerdas

eoría de cuerdas – Gravedad cuántica – Gravedad cuántica de bucles – Universos paralelos – Supersimetría – Teoría del todo – Antigravedad – Una teoría del todo excepcionalmente simple

La física experimental es el conjunto de disciplinas y subdisciplinas del campo de la física que tienen que ver con la observación de los fenómenos y experimentos físicos. Los métodos de cada una de las disciplinas son distintos: experimentos simples y observaciones, como el experimento de Cavendish, u otros más complicados, como el Gran Colisionador de Hadrones.En el día de hoy la física tiene un alto alto grado de importancia en nuestra sociedad, ya que vivimos en constante proceso determinista configurado por las leyes del universo.

Es ante todo una ciencia experimental, pues sus principios y leyes se fundamentan en la experiencia adquirida al reproducir intencionalmente muchos de los fenómenos; sin embargo, al aplicar el método científico experimental, el cual consiste en variar en lo posible las circunstancias en que un fenómeno se reproduce para obtener datos e interpretarlos, se pueden encontrar respuestas concretas y satisfactorias a fin de comprender cada día más el mundo donde vivimos.

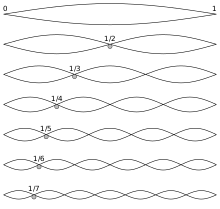

Experimento de Melde

La geofísica es la ciencia que se encarga del estudio de la Tierra desde el punto de vista de la física. Su objeto de estudio abarca todos los fenómenos relacionados con la estructura, condiciones físicas e historia evolutiva de la Tierra. Al ser una disciplina principalmente experimental, usa para su estudio métodos cuantitativos físicos como la física de reflexión y refracción de ondas mecánicas, y una serie de métodos basados en la medida de la gravedad, de campos electromagnéticos, magnéticos o eléctricos y de fenómenos radiactivos. En algunos casos dichos métodos aprovechan campos o fenómenos naturales (gravedad, magnetismo terrestre, mareas, terremotos, tsunamis, etc.) y en otros son inducidos por el hombre (campos eléctricos y fenómenos sísmicos).

Dentro de la geofísica se distinguen dos grandes ramas: La geofísica interna y la geofísica externa.

La geofísica interna analiza el interior de la Tierra y las principales cuestiones que estudia son:

- Sismología, estudia la estructura interna de la Tierra, el movimiento de las placas tectónicas y los movimientos telúricos, entre otros, valiéndose principalmente del análisis sismogramas que registran la propagación de ondas elásticas (sísmicas) y de observaciones GPS que registran el movimiento de las placas tectónicas.

- Geotermometría, estudia procesos relacionados con la propagación de calor en el interior de la Tierra, particularmente los relacionados con desintegraciones radioactivas y vulcanismo.

- Geodinámica, la interacción de esfuerzos y deformaciones en la Tierra que causan movimiento del manto y de la litosfera.

- Prospección geofísica, usa métodos cuantitativos para la localización de recursos naturales como petróleo, agua, yacimientos de minerales, cuevas, etc o artificiales como yacimientos arqueológicos.

- Ingeniería geofísica o geotecnia, usa métodos cuantitativos de prospección para la ubicación de yacimientos de minerales e hidrocarburos, así como para las obras públicas y construcción en general.

- Tectonofísica, estudia los procesos tectónicos.

- Vulcanología, Es el estudio de los volcanes, la lava, el magma y otros fenómenos geológicos relacionados.

La geofísica externa estudia las propiedades físicas del entorno terrestre.

- Geomagnetismo, estudia el campo magnético terrestre, tanto el interno generado por la propia Tierra como el externo, inducido por la Tierra y por el viento solar en la ionosfera.

- Paleomagnetismo, se ocupa del estudio del campo magnético terrestre en épocas anteriores del planeta.

- Gravimetría, estudia el campo gravitatorio terrestre a través de observaciones en tierra y observaciones satelitales.

- Oceanografía u Oceanología, estudia el océano en todas sus escalas. Desde fenómenos locales, hasta fenómenos globales como El Niño.

- Meteorología, estudia la atmósfera y el tiempo atmosférico, circunscribiéndose a la Tropósfera.

- Aeronomía, es la ciencia que estudia las capas superiores de la atmósfera, donde los fenómenos de ionización y disociación son importantes, desde el punto de vista físico y químico.

- Climatología, estudia el clima terrestre actual y en el pasado geológico.

- Geofísica Espacial, estudia los procesos físicos ligados al plasma presente en la ionosfera y la magnetósfera, y su interacción con el viento solar. La geofísica espacial es principalmente reconocida por el estudio de la transferencia de energía en la magnetósfera que da origen a las auroras polares.

Terremoto

Física del estado sólido y materia condensada

Física del estado sólido – Cristal – Superconductividad

Magnitud física

Una magnitud física es un valor asociado a una propiedad física o cualidad medible de un sistema físico, es decir, a la que se le pueden asignar distintos valores como resultado de una medición o una relación de medidas. Las magnitudes físicas se miden usando un patrón que tenga bien definida esa magnitud, y tomando como unidad la cantidad de esa propiedad que posea el objeto patrón. Por ejemplo, se considera que el patrón principal de longitud es el metro en el Sistema Internacional de Unidades.

Existen magnitudes básicas y derivadas, que constituyen ejemplos de magnitudes físicas: la masa, la longitud, el tiempo, la carga eléctrica, la densidad, la temperatura, la velocidad, la aceleración y la energía. En términos generales, es toda propiedad de los cuerpos o sistemas que puede ser medida. De lo dicho se desprende la importancia fundamental del instrumento de medición en la definición de la magnitud.

La Oficina Internacional de Pesas y Medidas, por medio del Vocabulario Internacional de Metrología (International Vocabulary of Metrology, VIM), define a la magnitud como un atributo de un fenómeno, un cuerpo o sustancia que puede ser distinguido cualitativamente y determinado cuantitativamente. A diferencia de las unidades empleadas para expresar su valor, las magnitudes físicas se expresan en cursiva: así, por ejemplo, la «masa» se indica con m, y «una masa de 3 kilogramos» la expresaremos como m = 3 kg.

Tipos de magnitudes físicas

Las magnitudes físicas pueden ser clasificadas de acuerdo a varios criterios:

- Según su expresión matemática, las magnitudes se clasifican en escalares, vectoriales y tensoriales

- Según su actividad, se clasifican en magnitudes extensivas e intensivas

Magnitudes escalares, vectoriales y tensoriales

- Las magnitudes escalares son aquellas que quedan completamente definidas por un número y las unidades utilizadas para su medida. Esto es, las magnitudes escalares están representadas por el ente matemático más simple, por un número. Podemos decir que poseen un módulo pero carecen de dirección. Su valor puede ser independiente del observador (v.g.: la masa, la temperatura, la densidad, etc.) o depender de la posición (v.g.: la energía potencial), o estado de movimiento del observador (v.g.: la energía cinética).

- Las magnitudes vectoriales son aquellas que quedan caracterizadas por una cantidad (intensidad o módulo), una dirección y un sentido. En un espacio euclidiano, de no más de tres dimensiones, un vector se representa mediante un segmento orientado. Ejemplos de estas magnitudes son: la velocidad, la aceleración, la fuerza, el campo eléctrico, intensidad luminosa, etc.

- Además, al considerar otro sistema de coordenadas asociado a un observador con diferente estado de movimiento o de orientación, las magnitudes vectoriales no presentan invariancia de cada uno de los componentes del vector y, por tanto, para relacionar las medidas de diferentes observadores se necesitan relaciones de transformación vectorial. En mecánica clásica el campo electrostático se considera un vector; sin embargo, de acuerdo con la teoría de la relatividad esta magnitud, al igual que el campo magnético, debe ser tratada como parte de una magnitud tensorial.

- Las magnitudes tensoriales son las que caracterizan propiedades o comportamientos físicos modelizables mediante un conjunto de números que cambian tensorialmente al elegir otro sistema de coordenadas asociado a un observador con diferente estado de movimiento (marco móvil) o de orientación.

De acuerdo con el tipo de magnitud, debemos escoger leyes de transformación (por ej. la transformación de Lorentz) de las componentes físicas de las magnitudes medidas, para poder ver si diferentes observadores hicieron la misma medida o para saber qué medidas obtendrá un observador, conocidas las de otro cuya orientación y estado de movimiento respecto al primero sean conocidos.

Magnitudes extensivas e intensivas

Una magnitud extensiva es una magnitud que depende de la cantidad de sustancia que tiene el cuerpo o sistema. Las magnitudes extensivas son aditivas. Si consideramos un sistema físico formado por dos partes o subsistemas, el valor total de una magnitud extensiva resulta ser la suma de sus valores en cada una de las dos partes. Ejemplos: la masa y el volumen de un cuerpo o sistema, la energía de un sistema termodinámico, etc.

Una magnitud intensiva es aquella cuyo valor no depende de la cantidad de materia del sistema. Las magnitudes intensivas tienen el mismo valor para un sistema que para cada una de sus partes consideradas como subsistemas. Ejemplos: la densidad, la temperatura y la presión de un sistema termodinámico en equilibrio.

En general, el cociente entre dos magnitudes extensivas da como resultado una magnitud intensiva. Ejemplo: masa dividida por volumen representa densidad

Aceleración – Fuerza – Interacciones fundamentales – Física – Física clásica – Masa – Peso – Potencia – Velocidad – Oscilador armónico

Biofísica

La biofísica es la ciencia que estudia la biología con los principios y métodos de la física. Se discute si la biofísica es una rama de la física o de la biología. Desde un punto de vista puede concebirse que los conocimientos y enfoques acumulados en la física «pura» pueden aplicarse al estudio de sistemas biológicos. En ese caso la biofísica le aporta conocimientos a la biología, pero no a la física, sin embargo, le ofrece a la física evidencia experimental que permite corroborar teorías. Ejemplos en ese sentido son la física de la audición, la biomecánica, los motores moleculares, comunicación molecular, entre otros campos de la biología abordada por la física.

Otros estudios consideran que existen ramas de la física que deben desarrollarse a profundidad como problema

poderlos tratar como un sistema mecánico, a la vez que no son lo suficientemente pequeños como para tratarlos como moléculas simples en solución. Los cambios energéticos que ocurren durante una reacción química catalizada por una enzima, o fenómenos como el acoplamiento químico-osmótico parecen requerir más de un enfoque físico teórico profundo que de una evaluación biológica.Entre esos dos extremos aparecen problemas como la generación y propagación del impulso nervioso donde se requiere un pensamiento biológico, más un pensamiento físico así como algo cualitativamente nuevo que aparece con la visión integradora del problema.

Una subdisciplina de la biofísica es la dinámica molecular, que intenta explicar las propiedades químicas de las biomoléculas a través de su estructura y sus propiedades dinámicas y de equilibrio.

Ramas de la Biofísica

- Biomecánica: Estudia los modelos, fenómenos y leyes que sean relevantes en el movimiento (incluyendo el estático) de los seres vivos (cinemática y dinámica), así como la respuesta estructural de diferentes partes del cuerpo.

- Bioacústica: Usualmente se refiere a la investigación de la producción del sonido, su dispersión a través de un medio y su recepción en animales.

- Motores moleculares: Estudia cómo macromoléculas (principalmente proteínas o ARN) realizan trabajo mecánico para llevar a cabo su función.

- Dinámica protéica: Estudia de movimientos moleculares de proteínas relacionados con su estructura, plegamiento o función.

- Comunicación molecular: La transmisión y recepción de información por medio de las moléculas.

Modelo de Hodgkin y Huxley – Potencial de acción

Historia de la Física

Emil Julius Klaus Fuchs – Albert Einstein – Robert Oppenheimer – Henri Poincaré – Isaac Newton

La física es la ciencia de las propiedades de la materia y de las fuerzas naturales. Sus formulaciones son en general compactas expresadas en lenguaje matemático.

La introducción de la investigación experimental y la aplicación del método matemático contribuyeron para la distinción entre física, filosofía y religión, que originalmente, tenían como objetivo común comprender el origen y la constitución del universo.

La física estudia la materia en los niveles molecular, atómico, nuclear y subnuclear. Estudia los niveles de organización, o sea, los estados sólido, líquido, gaseoso y plasmático de la materia.

Investiga también las cuatro fuerzas fundamentales: la de gravedad (fuerza de atracción ejercida por todas las partículas del universo), la electromagnética (que enlaza los electrones a los núcleos, la interacción fuerte (que mantiene la cohesión del núcleo) y la interacción débil (responsable por la desintegración de ciertas partículas).

La física experimental investiga las propiedades de la materia y de sus transformaciones por medio de transformaciones y medidas, generalmente realizadas en condiciones de laboratorio universalmente repetibles. La física teórica sistematiza los resultados experimentales, establece relaciones entre conceptos y constantes físicas y permite prever fenómenos inéditos.

Hechos Históricos

La física se desarrolla en función de la necesidad del hombre de conocer el mundo natural y controlar y reproducir las fuerzas de la naturaleza en su beneficio.

Física en la Antigüedad

Fue en la Grecia antigua que son realizados los primeros estudios “científicos” sobre los fenómenos de la naturaleza. Surgen los “filósofos naturales” interesados en racionalizar el mundo sin recurrir a la intervención divina.

Atomistas Griegos

La primera teoría atómica comienza en Grecia en el siglo V A.c. Leucipo, de Mileto y su alumno Demócrito, formulan las primeras hipótesis sobre los componentes esenciales de la materia.

Según ellos, el universo se compone de átomos y vacío. Los átomos son infinitos y no puede ser cortados o divididos. Son sólidos, pero de tamaño tan reducido que no pueden ser vistos. Están siempre en movimiento en el vacío.

Física Aristotélica

Es con Aristóteles que la física y demás ciencias ganaron más impulso en la antigüedad. Sus principales aportaciones a la física de las ideas sobre el movimiento, caída de cuerpos pesados (llamados “graves”, de ahí el origen de la palabra “gravedad”) y el geocentrismo. La lógica aristotélica dominará los estudios de la física hasta el final de la Edad Media en cuanto a los conceptos de gravedad y geocentrismo.

Revolución Copernicana

En 1510 Nicolau Copérnico rompió con más de diez siglos de dominio del geocentrismo. En su libro “Commentariolus”, dice por primera vez que la Tierra no es el centro del universo, sino uno de muchos planetas que giran alrededor del Sol. Con esta afirmación se enfrenta directamente a la Iglesia Católica, que había adoptado el sistema de Aristóteles como un dogma y hace que la física se vuelva un campo de estudio específico.

Para muchos historiadores, la revolución copernicana se consolida sólo un siglo más tarde, con los descubrimientos telescópicos y la mecánica de Galileo (1564-1642) y las leyes del movimiento planetario de Johannes Kepler (1571-1630).

Física Clásica

El siglo XVII sentó las bases para la Física de la era industrial. Simon Stevin desarrolla la hidrostática, la ciencia fundamental para su país (Holanda), protegida del mar por diques y esclusas. Una contribución equivalente fue la dada por su compatriota Christiaan Huygens, que desarrolló teorías sobre la propagación de la luz. Huygens es el primero en describir la luz como una onda. Pero fué Isaac Newton (1642-1727), científico Inglés, el gran nombre de la época: le pertenecen la teoría general de la mecánica y la gravitación universal y cálculo infinitesimal.

Física Aplicada

Termodinámica

Estudia las relaciones entre el calor y el trabajo. Se basa en dos principios: el de la conservación de energía y el de entropía. Estos principios son la base de las máquinas a vapor, turbinas, motores de combustión interna, motores de propulsión y máquinas frigoríficas.

Electromagnetismo

En 1820, el dinamarqués Hans Oersted relaciona los fenómenos eléctricos a los magnéticos al observar como la corriente eléctrica alteraba el movimiento de la aguja de una brújula. Michel Faraday invierte la experiencia de Oersted y verifica que los magnetos ejercen acción mecánica sobre los conductores recorridos por la corriente eléctrica y descubre la inducción electromagnética, que tendrá gran aplicación en las nuevas redes de distribución de energía.

Estructura del Átomo

En 1803, John Dalton comienza a presentar su teoría de que cada elemento químico corresponde a un tipo de átomo; pero es solo en 1897 con el descubrimiento del electrón, que el átomo deja de ser una unidad indivisible como se creía desde la antigüedad.

Era Cuántica

La gran revolución que lleva a la física a la modernidad es la teoría cuántica, que comienza a definirse a finales del siglo XIX. Es la inauguración de una nueva lógica resultante de las varias investigaciones sobre la estructura del átomo, radioactividad y ondulatoria.

Max Planck es quien define el concepto fundamental de la nueva teoría “el quanta”. Pero la teoría general es de autoría de un grupo internacional de físicos entre los cuales se encuentran Niels Bohr (Dinamarca), Louis De Broglie (França), Erwin, Shrödinger y Wolfgang , Pauli (Áustria), Werner Heisenberg (Alemanha), y Paul Dirac (Inglaterra).

Relatividad

La Teoría de la relatividad surge en dos etapas y altera profundamente las nociones de espacio y tiempo. En cuanto la mecánica cuántica es el resultado del trabajo de varios físicos y matemáticos, la relatividad es fruto exclusivo de las investigaciones de Albert Einstein.

Partículas Subatómicas

La historia de las partículas que componen el átomo bastante reciente. Sólo en 1932 se confirma que los átomos están constituidos por neutrones, protones y electrones. A continuación se encuentran partículas aún más pequeñas como el positrón ó neutrino y el mesón (una partícula intranuclear de vida muy breve (2.6 cienmillonésimas de segundo).

Tendencias Actuales

La fusión nuclear controlada y la física de los primeros instantes del Universo son actualmente los campos más desafiantes de la física.